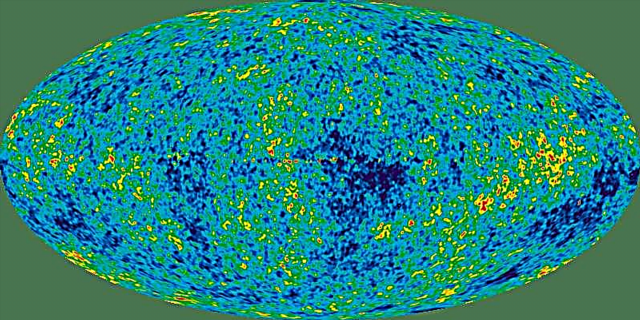

Dall'inizio del 20 ° secolo, scienziati e fisici sono stati gravati di spiegare come e perché l'Universo sembra espandersi a un ritmo accelerato. Oltre ad essere responsabile dell'accelerazione cosmica, si ritiene che questa energia comprenda il 68,3% della massa non visibile dell'universo.

Proprio come la materia oscura, l'esistenza di questa forza invisibile si basa su fenomeni osservabili e perché coincide con i nostri attuali modelli di cosmologia e non con prove dirette. Invece, gli scienziati devono fare affidamento su osservazioni indirette, osservando quanto velocemente gli oggetti cosmici (in particolare le supernovae di Tipo Ia) si allontanano da noi mentre l'universo si espande.

Questo processo sarebbe estremamente noioso per gli scienziati - come quelli che lavorano per il Dark Energy Survey (DES) - se non fosse per i nuovi algoritmi sviluppati in collaborazione dai ricercatori del Lawrence Berkeley National Laboratory e UC Berkeley.

"Il nostro algoritmo è in grado di classificare il rilevamento di un candidato di supernova in circa 0,01 secondi, mentre uno scanner umano esperto può richiedere diversi secondi", ha affermato Danny Goldstein, uno studente laureato alla Berkeley della UC che ha sviluppato il codice per automatizzare il processo di scoperta di supernova sulle immagini DES .

Attualmente nella sua seconda stagione, il DES scatta foto notturne del Southern Sky con DECam, una fotocamera da 570 megapixel montata sul telescopio Victor M. Blanco al Cerro Tololo Interamerican Observatory (CTIO) nelle Ande cilene. Ogni notte, la fotocamera genera tra 100 Gigabyte (GB) e 1 Terabyte (TB) di dati di imaging, che vengono inviati al National Center for Supercomputing Applications (NCSA) e al Fermilab del DOE in Illinois per l'elaborazione iniziale e l'archiviazione.

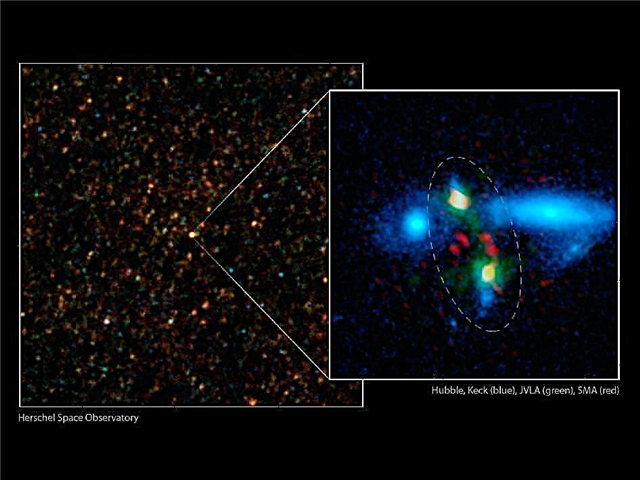

I programmi di riconoscimento degli oggetti sviluppati presso il National Science Research Scientific Computing Center (NERSC) e implementati presso l'NCSA, poi analizzano le immagini alla ricerca di possibili rilevazioni di supernovae di tipo Ia. Queste potenti esplosioni si verificano in sistemi stellari binari in cui una stella è una nana bianca, che accumula materiale da una stella compagna fino a raggiungere una massa critica ed esplode in una supernova di tipo Ia.

"Queste esplosioni sono notevoli perché possono essere utilizzate come indicatori di distanza cosmica con un'accuratezza del 3-10 percento", afferma Goldstein.

La distanza è importante perché più lontano si trova un oggetto nello spazio, più indietro nel tempo lo è. Tracciando le supernovae di tipo Ia a diverse distanze, i ricercatori possono misurare l'espansione cosmica nella storia dell'universo. Ciò consente loro di porre dei limiti alla velocità con cui l'universo si sta espandendo e forse fornire anche altri indizi sulla natura dell'energia oscura.

"Scientificamente, è un momento davvero emozionante perché diversi gruppi in tutto il mondo stanno cercando di misurare con precisione le supernovae di tipo Ia al fine di limitare e comprendere l'energia oscura che sta guidando l'espansione accelerata dell'universo", afferma Goldstein, che è anche uno studente ricercatrice presso il Computational Cosmology Center (C3) di Berkeley Lab.

Il DES inizia la sua ricerca di esplosioni di tipo Ia scoprendo i cambiamenti nel cielo notturno, che è dove entra in gioco la pipeline di sottrazione di immagini sviluppata e implementata dai ricercatori nel gruppo di lavoro della supernova DES. La pipeline sottrae immagini che contengono oggetti cosmici noti da nuove immagini che sono esposti ogni notte al CTIO.

Ogni notte, il gasdotto produce tra 10.000 e alcune centinaia di migliaia di rilevamenti di candidati di supernova che devono essere convalidati.

“Storicamente, gli astronomi addestrati si sono seduti al computer per ore, guardavano questi punti e offrivano opinioni sul fatto che avessero le caratteristiche di una supernova o se fossero causati da effetti spuri che si mascheravano come supernove nei dati. Questo processo sembra semplice fino a quando non ti rendi conto che il numero di candidati che devono essere classificati ogni notte è proibitivamente grande e solo uno su poche centinaia è una vera supernova di qualsiasi tipo ", afferma Goldstein. “Questo processo è estremamente noioso e richiede molto tempo. Fa anche molta pressione sul gruppo di lavoro della supernova per elaborare e scansionare i dati velocemente, il che è un duro lavoro. ”

Per semplificare il compito di controllare i candidati, Goldstein ha sviluppato un codice che utilizza la tecnica di apprendimento automatico "Foresta casuale" per controllare i rilevamenti dei candidati di supernova automaticamente e in tempo reale per ottimizzarli per il DES. La tecnica impiega un insieme di alberi decisionali per porre automaticamente i tipi di domande che gli astronomi prenderebbero in considerazione nella classificazione dei candidati alle supernova.

Alla fine del processo, a ciascun rilevamento di un candidato viene assegnato un punteggio basato sulla frazione degli alberi decisionali che lo considerano avere le caratteristiche di un rilevamento di una supernova. Più il punteggio di classificazione è vicino a uno, più forte è il candidato. Goldstein osserva che nei test preliminari, la pipeline di classificazione ha raggiunto un'accuratezza complessiva del 96 percento.

"Quando fai la sottrazione da solo ottieni troppi" falsi positivi "- artefatti strumentali o software che si presentano come potenziali candidati alle supernova - per consentire agli umani di setacciarli", afferma Rollin Thomas, del C3 di Berkeley Lab, che era il collaboratore di Goldstein.

Osserva che con il classificatore, i ricercatori possono sforzare in modo rapido e accurato i manufatti dei candidati alla supernova. "Ciò significa che invece di avere 20 scienziati del gruppo di lavoro della supernova setacciare continuamente migliaia di candidati ogni notte, puoi semplicemente nominare una persona per guardare forse alcune centinaia di candidati forti", afferma Thomas. "Questo accelera notevolmente il nostro flusso di lavoro e ci consente di identificare le supernovae in tempo reale, il che è cruciale per condurre osservazioni di follow-up."

"Utilizzando circa 60 core su un supercomputer possiamo classificare 200.000 rilevamenti in circa 20 minuti, incluso il tempo per l'interazione con il database e l'estrazione delle funzionalità." dice Goldstein.

Goldstein e Thomas notano che il prossimo passo in questo lavoro è aggiungere un pipeline di secondo livello all'apprendimento automatico per migliorare l'accuratezza della classificazione. Questo livello aggiuntivo prenderebbe in considerazione il modo in cui l'oggetto è stato classificato nelle precedenti osservazioni in quanto determina la probabilità che il candidato sia "reale". I ricercatori e i loro colleghi stanno attualmente lavorando su diversi approcci per raggiungere questa capacità.